- Published on

100 bài luyện tập xử lý ngôn ngữ tự nhiên

- Authors

- Name

- Kevin Nguyen

Dịch từ tài liệu 言語処理 100 本ノック 2020 của lab Inui-Okazaki, đại học Tohoku, Nhật Bản. Người dịch: Phạm Quang Nhật Minh (minhpqn).

Note: Khác với phiên bản 2005, phiên bản 2020 bổ sung 3 chương 8, 9, 10 về các nội dung liên quan đến mô hình Neural Networks.

Các lời giải được sưu tầm1

Chương 1: Bài tập khởi động

00. Đảo ngược xâu ký tự

Đảo ngược xâu ký tự "stressed" (theo thứ tự từ cuối xâu đến đầu xâu ký tự).

s = "stressed"

r_s = "".join([c for c in reversed(s)])

print(r_s)

desserts

01. "schooled"

Tạo một xâu kí tự bằng cách nối các kí tự ở vị trí 1, 3, 5, 7 trong xâu kí tự "schooled".

s = "schooled"

ret_s = "".join([c for c in s[1:8:2]])

print(ret_s)

cold

02. "shoe" + "cold" = "schooled"

Tạo xâu kí tự "schooled" bằng cách nối các kí tự trong "shoe" và "cold" luân phiên nhau từ đầu đến cuối.

s1="shoe"

s2="cold"

s = "".join([c1+c2 for c1, c2 in zip(s1, s2)])

print(s)

schooled

03. Pi

Tách câu "Now I need a drink, alcoholic of course, after the heavy lectures involving quantum mechanics." thành các từ và tạo ra một danh sách (list) mà mỗi thành phần của nó biểu thị số các kí tự alphabet trong từ tương ứng.

s = "Now I need a drink, alcoholic of course, after the heavy lectures involving quantum mechanics."

for word in s.strip().split(' '):

print("----{}----".format(word))

c_count = {}

for c in word:

#print(c)

if c in c_count:

c_count[c] += 1

else:

c_count[c] = 1

for k, v in sorted(c_count.items(), key=lambda x:x[1], reverse=True):

print(k, v)

----Now----

N 1

o 1

w 1

----I----

I 1

----need----

e 2

n 1

d 1

----a----

a 1

----drink,----

d 1

r 1

i 1

n 1

k 1

, 1

----alcoholic----

l 2

c 2

o 2

a 1

h 1

i 1

----of----

o 1

f 1

----course,----

c 1

o 1

u 1

r 1

s 1

e 1

, 1

----after----

a 1

f 1

t 1

e 1

r 1

----the----

t 1

h 1

e 1

----heavy----

h 1

e 1

a 1

v 1

y 1

----lectures----

e 2

l 1

c 1

t 1

u 1

r 1

s 1

----involving----

i 2

n 2

v 2

o 1

l 1

g 1

----quantum----

u 2

q 1

a 1

n 1

t 1

m 1

----mechanics.----

c 2

m 1

e 1

h 1

a 1

n 1

i 1

s 1

. 1

04. Atomic symbols

Tách câu "Hi He Lied Because Boron Could Not Oxidize Fluorine. New Nations Might Also Sign Peace Security Clause. Arthur King Can." thành các từ và trích xuất kí tự đầu tiên của các từ ở vị trí 1, 5, 6, 7, 8, 9, 15, 16, 19 và hai kí tự đầu tiên của các từ còn lại. Tạo một mảng kết hợp (đối tượng dạng dictionary hoặc mapping) ánh xạ từ xâu được trích xuất tới vị trí (offset ở trong câu) của từ tương ứng.

pop_idx_1 = [1, 5, 6, 7, 8, 9, 15, 16, 19]

s = "Hi He Lied Because Boron Could Not Oxidize Fluorine. New Nations Might Also Sign Peace Security Clause. Arthur King Can."

ret = {}

for i, word in enumerate(s.strip().split(' ')):

if i+1 in pop_idx_1:

ret[i] = word[0]

elif len(word) > 1:

ret[i] = word[1]

print(ret)

{0: 'H', 1: 'e', 2: 'i', 3: 'e', 4: 'B', 5: 'C', 6: 'N', 7: 'O', 8: 'F', 9: 'e', 10: 'a', 11: 'i', 12: 'l', 13: 'i', 14: 'P', 15: 'S', 16: 'l', 17: 'r', 18: 'K', 19: 'a'}

05. n-gram

Viết hàm sinh ra tất cả các n-gram từ một dãy cho trước (xâu kí tự hoặc danh sách). Sử dụng hàm đã viết, sinh ra word bi-gram và character bi-gram từ câu "I am an NLPer"

def get_ngram(s, N):

words = s.strip().split(' ')

word_bi_gram = [words[i: i + N] for i in range(len(words) - N + 1)]

letter_bi_gram = [s[i: i + N] for i in range(len(s) - N + 1)]

return word_bi_gram, letter_bi_gram

s = "I am an NLPer"

get_ngram(s, 2)

([['I', 'am'], ['am', 'an'], ['an', 'NLPer']],

['I ', ' a', 'am', 'm ', ' a', 'an', 'n ', ' N', 'NL', 'LP', 'Pe', 'er'])

06. Tập hợp

- Sinh ra tập X và Y tương ứng là tập các character bi-gram từ hai xâu ký tự "paraparaparadise" và "paragraph".

- Sinh ra các tập hợp union, intersection và difference của X và Y

- Kiểm tra xem bi-gram 'se' có thuộc tập X và Y hay không?

def get_ngram(s, N, mode='leter'):

words = s.strip().split(' ')

if mode == 'word':

bi_gram = [words[i: i + N] for i in range(len(words) - N + 1)]

elif mode == 'leter':

bi_gram = [s[i: i + N] for i in range(len(s) - N + 1)]

return bi_gram

X = set(get_ngram(s="paraparaparadise", N=2, mode='leter'))

Y = set(get_ngram(s="paragraph", N=2, mode='leter'))

print(X, Y)

print(X.union(Y))

print(X.intersection(Y))

print(X.difference(Y))

print('se' in X)

print('se' in Y)

{'ap', 'ar', 'ad', 'is', 'pa', 'se', 'di', 'ra'} {'ra', 'ph', 'ap', 'ar', 'gr', 'pa', 'ag'}

{'ph', 'ap', 'ar', 'gr', 'ad', 'is', 'pa', 'ag', 'se', 'di', 'ra'}

{'ap', 'ar', 'pa', 'ra'}

{'di', 'is', 'se', 'ad'}

True

False

07. Sinh ra câu từ template

Viết hàm số nhận vào 3 biến x, y, z và trả về xâu ký tự "y vào lúc x giờ là z", trong đó x, y và z thể hiện giá trị của x, y, z. Sinh ra kết quả với các giá trị x, y, z sau đây x="12" y="Nhiệt độ" z=22.4

def generate(x, y, z):

return '%s vào lúc %s giờ là %s' %(str(y), str(x), str(z))

def main():

print(generate(12,"Nhiệt độ", 22.4))

if __name__ == '__main__':

main()

Nhiệt độ vào lúc 12 giờ là 22.4

08. Xâu mật mã

Từ các ký tự của một xâu cho trước, cài đặt hàm có tên cipher để mã hoá xâu như sau:

- Mọi ký tự tiếng Anh ở dạng thường (lower-case characters) c được chuyển thành ký tự có mã là (219 - [mã ký tự ASCII của c]).

- Các ký tự khác giữ nguyên.

Sử dụng hàm đã viết để mã hoá và giải mã các xâu ký tự tiếng Anh.

import re

lowerReg = re.compile(r'^[a-z]+$')

def cipher(s):

if lowerReg.match(s):

return "".join([chr(219 - ord(c)) for c in s])

else:

return s

print(cipher(s='cipher'))

xrksvi

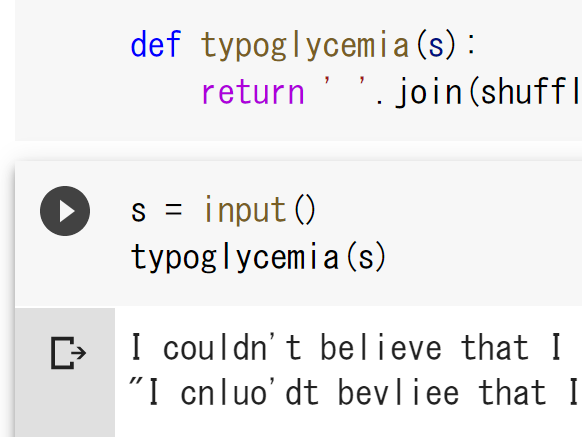

09. Typoglycemia

Viết chương trình thực hiện việc sau:

- Nhận đầu vào là một câu tiếng Anh bao gồm các word ngăn cách nhau bằng ký tự space.

- Với mỗi word trong câu:

- Nếu word đó không có nhiều hơn 4 kí tự, giữ nguyên word đó

- Nếu không,

- Giữ nguyên kí tự đầu và kí tự cuối của word

- Đảo thứ tự một cách ngẫu nhiên các kí tự ở những vị trí khác (ở giữa của word đó).

Cho trước một câu tiếng Anh hợp lệ, ví dụ "I couldn't believe that I could actually understand what I was reading : the phenomenal power of the human mind .", chạy chương trình đã viết để đưa ra kết quả.

import random

def typoglycemia(s):

words = [word for word in s.strip().split(' ')]

if len(word) <= 4:

return s

ret = words[1:-2]

random.shuffle(ret)

ret.insert(0, words[0])

ret.append(words[-1])

return " ".join(ret)

print(typoglycemia(s = "I couldn't believe that I could actually understand what I was reading : the phenomenal power of the human mind ."))

print(typoglycemia(s ="a b c d"))

I couldn't believe that I could actually understand what I was reading : the phenomenal power of the human mind .

a b c d

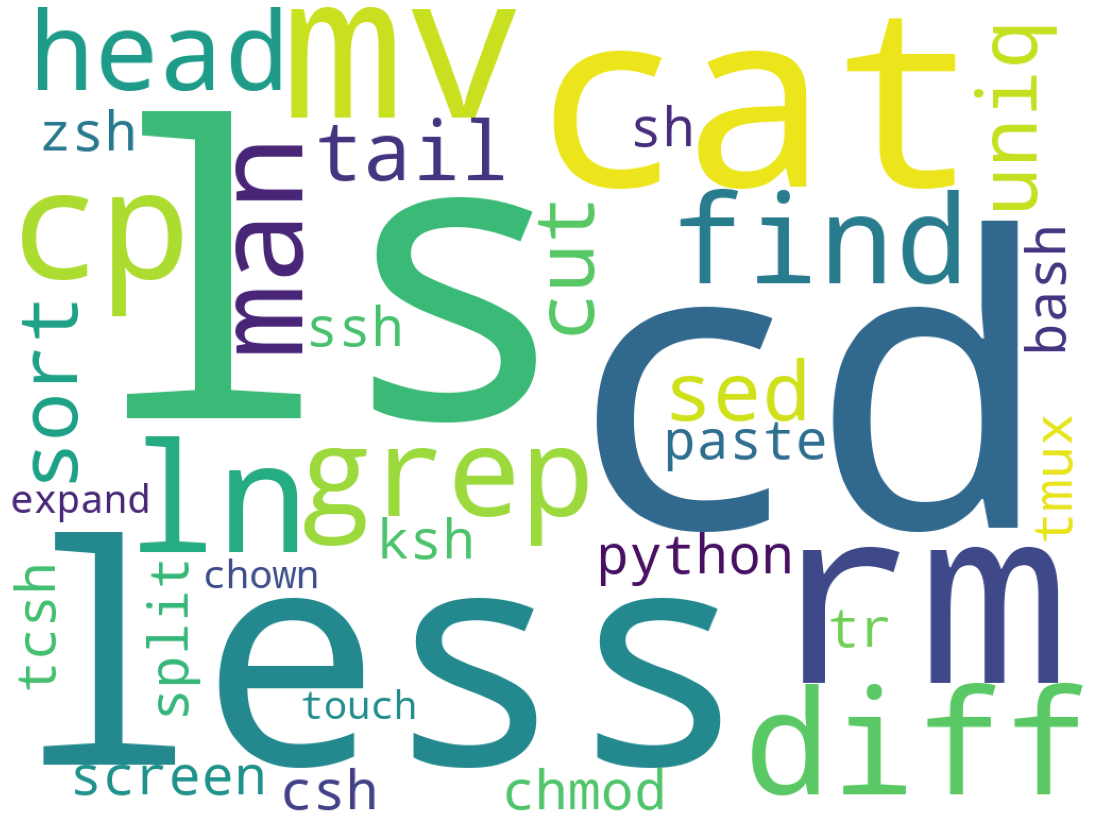

Chương 2: Các lệnh cơ bản trên môi trường UNIX

Tệp popular-names.txt là một tệp ở định dạng phân cách bằng dấu tab, lưu trữ "tên", "giới tính", "số người" và "năm sinh" của các em bé được sinh ra ở Hoa Kỳ. Viết chương trình thực hiện các xử lý sau đây. Tệp popular-names.txt là đầu vào của của chương trình. Sau đó, chỉ dùng cách lệnh trong UNIX để thực hiện cùng các nhiệm vụ và xác nhận xem kết quả các lệnh UNIX đưa ra có giống với kết quả của chương trình bạn viết hay không.

!wget https://nlp100.github.io/data/popular-names.txt

10. Đếm số dòng trong file

Đếm số dòng trong file. Xác nhận kết quả bằng lệnh wc trong unix.

input_file = 'popular-names.txt'

with open(input_file, 'r') as f:

print(sum([1 for _ in f]))

!wc -l $input_file

2780

2780 popular-names.txt

11. Biến đổi các ký tự tab thành space

Chuyễn mỗi ký tự tab thành ký tự space. Xác nhận kết quả bằng các lệnh sed, tr hoặc expand.

input_file = 'popular-names.txt'

with open(input_file, 'r') as f:

for row in f:

row.replace('\t', ' ')

12. Lưu cột 1 vào file col1.txt, cột 2 vào file col2.txt

Trích xuất nội dung trong cột 1, cột 2 của các dòng trong file và lưu vào các file tương ứng: col1.txt và col2.txt. Thử thực hiện công việc với lệnh cut trong unix.

input_file = 'popular-names.txt'

with open(input_file, 'r') as input_f, \

open('col1.txt', 'w') as output_f1, \

open('col2.txt', 'w') as output_f2:

for row in input_f:

l = row.strip().split('\t')

output_f1.write(l[0] + '\n')

output_f2.write(l[1] + '\n')

!head $input_file

!head 'col1.txt'

!head 'col2.txt'

Mary F 7065 1880

Anna F 2604 1880

Emma F 2003 1880

Elizabeth F 1939 1880

Minnie F 1746 1880

Margaret F 1578 1880

Ida F 1472 1880

Alice F 1414 1880

Bertha F 1320 1880

Sarah F 1288 1880

Mary

Anna

Emma

Elizabeth

Minnie

Margaret

Ida

Alice

Bertha

Sarah

F

F

F

F

F

F

F

F

F

F

13. Trộn hai file col1.txt và col2.txt

Kết hợp nội dung trong 2 file col1.txt và col2.txt đã được tạo ra trong bài 12 để tạo thành một file mới có nội dung gồm cột 1 và cột 2 trong file ban đầu và các cột cách nhau bởi ký tự tab. Sử dụng lệnh paste để thực hiện bài tập và xác nhận kết quả của chương trình bạn viết.

with open('col1.txt', 'r') as input_f1, \

open('col2.txt', 'r') as input_f2, \

open('merge_col1_col2.txt', 'w') as output_f:

for row1, row2 in zip(input_f1, input_f2):

output_f.write("{}\t{}\n".format(row1.strip(), row2.strip()))

! head 'merge_col1_col2.txt'

Mary F

Anna F

Emma F

Elizabeth F

Minnie F

Margaret F

Ida F

Alice F

Bertha F

Sarah F

14. Trích xuất ra N hàng đầu tiên của file

Viết chương trình trích xuất ra N hàng đầu tiên của file. Biến số dòng lệnh là số tự nhiên N. Sử dụng lệnh head trong unix để thực hiện công việc.

def head(input_file, N):

with open(input_file, 'r') as f:

for row in f.readlines()[0:N]:

print(row.strip())

input_file = 'popular-names.txt'

head(input_file, N=5)

Mary F 7065 1880

Anna F 2604 1880

Emma F 2003 1880

Elizabeth F 1939 1880

Minnie F 1746 1880

15. Trích xuất ra N hàng cuối cùng của file

Viết chương trình trích xuất ra N hàng cuối cùng của file. Chương trình nhận đầu vào từ dòng lệnh số tự nhiên N. Sử dụng lệnh tail trong unix để thực hiện công việc.

def tail(input_file, N):

with open(input_file, 'r') as f:

for row in f.readlines()[-N::1]:

print(row.strip())

input_file = 'popular-names.txt'

tail(input_file, N=3)

! tail -n 3 $input_file

Lucas M 12585 2018

Mason M 12435 2018

Logan M 12352 2018

Lucas M 12585 2018

Mason M 12435 2018

Logan M 12352 2018

16. Chia file thành N phần

Nhận một số tự nhiên N từ đối số của dòng lệnh và chia file đầu vào thành N phần tại các ranh giới của các dòng (line boundaries). Xác nhận lại kết quả bằng lệnh split trong UNIX.

def split_line(input_file, N):

with open(input_file, 'r') as f:

l = f.readlines()

step = 1

for i in range(0, len(l), N):

step+=1

print('---step({})---'.format(step))

for data in l[i:i+N]:

print(data.strip())

input_file = 'popular-names.txt'

split_line(input_file, N=3)

! tail -n 6 $input_file

17. Các xâu phân biệt trong cột đầu tiên

Tìm các xâu phân biệt (một tập hợp các xâu) của cột đầu tiên của file. Xác nhận lại kết quả bằng cách dùng lệnh cut, sort và uniq.

def set_strings(input_file):

s = set()

with open(input_file, 'r') as f:

for row in f:

l = row.strip().split('\t')

s.add(l[0])

print(s)

input_file = 'popular-names.txt'

set_strings(input_file)

{'William', 'Amelia', 'Frank', 'Barbara', 'Noah', 'Abigail', 'George', 'Amy', 'Ava', 'Stephanie', 'Megan', 'Crystal', 'Elijah', 'Joan', 'Walter', 'Florence', 'Henry', 'Christopher', 'Mia', 'Betty', 'Tammy', 'Kathleen', 'Marie', 'Thomas', 'Julie', 'Pamela', 'Brian', 'Harper', 'Rebecca', 'Justin', 'Anthony', 'Joseph', 'Elizabeth', 'Doris', 'Isabella', 'Emma', 'Benjamin', 'Rachel', 'Jeffrey', 'Andrew', 'Linda', 'Dorothy', 'Daniel', 'Bessie', 'Frances', 'Judith', 'Ashley', 'Nicholas', 'Ronald', 'Karen', 'Alice', 'Kimberly', 'Steven', 'Oliver', 'Carolyn', 'Minnie', 'Laura', 'Logan', 'Deborah', 'Liam', 'Lisa', 'Anna', 'Matthew', 'Brandon', 'Lauren', 'Aiden', 'Angela', 'Lillian', 'Mary', 'Sandra', 'Cynthia', 'James', 'Susan', 'Donald', 'Ida', 'Amanda', 'Clara', 'Ruth', 'David', 'Jason', 'Scott', 'Harry', 'Chloe', 'Nancy', 'Ethan', 'Shirley', 'Richard', 'Hannah', 'Alexis', 'Sarah', 'Austin', 'Evelyn', 'Michael', 'Emily', 'Mark', 'Heather', 'Mason', 'Olivia', 'Helen', 'John', 'Edward', 'Lucas', 'Samantha', 'Ethel', 'Margaret', 'Debra', 'Nicole', 'Jayden', 'Donna', 'Madison', 'Alexander', 'Jennifer', 'Jacob', 'Lori', 'Brittany', 'Michelle', 'Carol', 'Joshua', 'Gary', 'Charlotte', 'Charles', 'Jessica', 'Virginia', 'Melissa', 'Mildred', 'Kelly', 'Patricia', 'Sharon', 'Tracy', 'Annie', 'Robert', 'Bertha', 'Sophia', 'Larry', 'Tyler', 'Taylor'}

18. Sắp xếp các dòng theo thứ tự giảm dần của cột thứ 3

Sắp xếp các dòng theo thứ tự giảm dần của các số trong cột thứ 3 (sắp xếp các dòng nhưng không thay đổi nội dung của trong mỗi dòng). Xác nhận lại kết quả với lệnh sort.

def reverse_col3(input_file):

ret = []

with open(input_file, 'r') as f:

for row in f:

l = row.strip().split('\t')

ret.append(int(l[2]))

print(sorted(ret, reverse=True))

input_file = 'popular-names.txt'

reverse_col3(input_file)

[99689, 96211, 94757, 92704, 91640, 91016, 90656, 90517, 88584, 88528, 88327, 88319, 87436, 87261, 87063, 86917, 86857, 86604, 86351, 86298, 86272, 86256, 86253, 86224, 86099, 85929, 85475, 85302, 85251, 85203, 85034, 84863, 84758, 84275, 84226, 84180, 84155, 84138, 83931, 83917, 83872, 83782, 83703, 83559, 83138, 82829, 82646, 82578, 82533, 82436, 82349, 82008, 81717, 81624, 81574, 81324, 81165, 81161, 81021, 80790, 80431, 80261, 80190, 80054, 79990, 79929, 79529, 79424, 79261, 79049, 78984, 78713, 78625, 78606, 78467, 78429, 77594, 77272, 77176, 76951, 76832, 76407, 76152, 76093, 75991, 75924, 75054, 74865, 74502, 74449, 73985, 73978, 73534, 73037, 72901, 72797, 72555, 72360, 72173, 71838, 71750, 71687, 71638, 71541, 71405, 71322, 70982, 70843, 70639, 70591, 70196, 70012, 70003, 69937, 68919, 68763, 68696, 68597, 68454, 68235, 68007, 68000, 67852, 67847, 67832, 67741, 67739, 67701, 67616, 67578, 67467, 67366, 67158, 67082, 66989, 66954, 66872, 66864, 66810, 66736, 66610, 66420, 66169, 66113, 66027, 65838, 65721, 65634, 65481, 65389, 65290, 65174, 65144, 65032, 64912, 64792, 64379, 64281, 64233, 64208, 64146, 64143, 63718, 63700, 63655, 63603, 63508, 63254, 63165, 63123, 63114, 63047, 62782, 62473, 62467, 62447, 62268, 62149, 61965, 61840, 61835, 61759, 61756, 61752, 61698, 61669, 61618, 61501, 61438, 61417, 61280, 61196, 61130, 61094, 60929, 60897, 60801, 60785, 60727, 60699, 60693, 60689, 60508, 60296, 60269, 60046, 60038, 60029, 59958, 59915, 59874, 59798, 59645, 59627, 59609, 59601, 59474, 59349, 59330, 59283, 59266, 59231, 59099, 59055, 58964, 58957, 58868, 58771, 58728, 58525, 58521, 58492, 58403, 58375, 58350, 58325, 58217, 58211, 58187, 58183, 58040, 57806, 57767, 57515, 57470, 57277, 57203, 57199, 57117, 57049, 57014, 56929, 56914, 56913, 56909, 56829, 56783, 56717, 56691, 56623, 56558, 56551, 56524, 56442, 56381, 56321, 56215, 56203, 56117, 56110, 56040, 55994, 55954, 55898, 55857, 55829, 55653, 55645, 55509, 55381, 55069, 55000, 54901, 54884, 54854, 54779, 54776, 54686, 54677, 54621, 54549, 54493, 54474, 54392, 54372, 54346, 54275, 54249, 54218, 54195, 53941, 53793, 53755, 53674, 53545, 53528, 53511, 53504, 53304, 53209, 53178, 53118, 53098, 52997, 52939, 52906, 52794, 52784, 52754, 52710, 52682, 52680, 52677, 52665, 52564, 52435, 52434, 52401, 52369, 52336, 52315, 52201, 52189, 52186, 52136, 52127, 52113, 51922, 51920, 51860, 51853, 51629, 51543, 51518, 51482, 51475, 51366, 51288, 51279, 51219, 51116, 51102, 51018, 51015, 51000, 50970, 50939, 50677, 50654, 50559, 50556, 50519, 50501, 50463, 50408, 50235, 50217, 50213, 50149, 50043, 49963, 49942, 49814, 49801, 49776, 49748, 49676, 49549, 49532, 49350, 49350, 49146, 49117, 49092, 48832, 48792, 48746, 48676, 48652, 48617, 48603, 48423, 48347, 48321, 48302, 48284, 48234, 48171, 48075, 47994, 47945, 47912, 47884, 47837, 47805, 47789, 47680, 47669, 47589, 47576, 47499, 47402, 47265, 47259, 47169, 47158, 47151, 47104, 47083, 47079, 47007, 47005, 46925, 46826, 46749, 46734, 46683, 46592, 46571, 46481, 46475, 46439, 46366, 46330, 46328, 46296, 46222, 46217, 46157, 46136, 46078, 46066, 46043, 45948, 45890, 45870, 45855, 45824, 45642, 45599, 45560, 45451, 45374, 45345, 45290, 45282, 45269, 45210, 45202, 45173, 45122, 45029, 44860, 44835, 44818, 44804, 44768, 44734, 44572, 44500, 44474, 44469, 44297, 44240, 44091, 43971, 43778, 43585, 43546, 43486, 43478, 43429, 43398, 43342, 43333, 43276, 43219, 43181, 43037, 42889, 42737, 42702, 42651, 42651, 42601, 42533, 42460, 42422, 42422, 42390, 42358, 42222, 42195, 42118, 42117, 42078, 42077, 42064, 42052, 41931, 41925, 41899, 41815, 41786, 41772, 41640, 41599, 41552, 41550, 41462, 41402, 41354, 41350, 41218, 41181, 41117, 41102, 41027, 40990, 40786, 40770, 40713, 40704, 40668, 40632, 40620, 40620, 40586, 40543, 40529, 40459, 40419, 40403, 40276, 40262, 40228, 40198, 40170, 40127, 40097, 40071, 40054, 40047, 40042, 40000, 39999, 39915, 39865, 39625, 39591, 39538, 39457, 39456, 39409, 39397, 39386, 39371, 39326, 39325, 39294, 39279, 39273, 39270, 39203, 39199, 39197, 39177, 39176, 39106, 39102, 39087, 39054, 39052, 39049, 39044, 38963, 38910, 38875, 38869, 38867, 38772, 38756, 38701, 38676, 38570, 38564, 38542, 38521, 38486, 38472, 38463, 38453, 38439, 38434, 38412, 38397, 38364, 38356, 38313, 38309, 38276, 38264, 38253, 38234, 38227, 38203, 38163, 38028, 38017, 37948, 37940, 37919, 37855, 37821, 37788, 37734, 37716, 37706, 37638, 37629, 37619, 37551, 37549, 37542, 37521, 37451, 37446, 37415, 37381, 37339, 37311, 37258, 37236, 37147, 37098, 37031, 36972, 36956, 36901, 36877, 36860, 36849, 36827, 36819, 36786, 36776, 36734, 36707, 36675, 36643, 36642, 36627, 36617, 36615, 36574, 36537, 36533, 36524, 36465, 36380, 36370, 36354, 36322, 36215, 36206, 36185, 36148, 36105, 36080, 36060, 36016, 35987, 35985, 35894, 35865, 35861, 35857, 35843, 35839, 35821, 35770, 35743, 35741, 35715, 35698, 35657, 35579, 35569, 35517, 35503, 35434, 35432, 35422, 35420, 35373, 35363, 35335, 35314, 35279, 35220, 35220, 35218, 35184, 35161, 35115, 35097, 35097, 35042, 35001, 34987, 34938, 34925, 34912, 34887, 34850, 34822, 34811, 34806, 34800, 34775, 34750, 34705, 34700, 34697, 34654, 34477, 34469, 34460, 34451, 34425, 34417, 34408, 34406, 34380, 34373, 34322, 34310, 34284, 34280, 34270, 34251, 34227, 34217, 34214, 34187, 34153, 34136, 34132, 34052, 34050, 34040, 34037, 34026, 34006, 33998, 33945, 33921, 33912, 33908, 33889, 33856, 33818, 33810, 33775, 33754, 33749, 33743, 33731, 33706, 33702, 33702, 33657, 33648, 33605, 33588, 33581, 33572, 33539, 33521, 33518, 33487, 33396, 33394, 33293, 33221, 33218, 33160, 33157, 33153, 33102, 33077, 32987, 32973, 32964, 32946, 32937, 32909, 32875, 32872, 32865, 32843, 32813, 32746, 32732, 32703, 32703, 32674, 32664, 32662, 32653, 32643, 32637, 32617, 32545, 32510, 32508, 32502, 32485, 32462, 32454, 32444, 32349, 32344, 32304, 32298, 32251, 32240, 32234, 32183, 32117, 32104, 32090, 32073, 32037, 32032, 31973, 31954, 31936, 31930, 31928, 31925, 31908, 31871, 31869, 31855, 31816, 31809, 31798, 31773, 31741, 31740, 31734, 31719, 31692, 31687, 31684, 31682, 31682, 31636, 31623, 31611, 31598, 31532, 31526, 31515, 31514, 31500, 31492, 31492, 31488, 31477, 31468, 31459, 31373, 31372, 31349, 31341, 31337, 31247, 31192, 31142, 31138, 31137, 31129, 31106, 31098, 31095, 31085, 31060, 31003, 30994, 30921, 30917, 30901, 30866, 30826, 30787, 30732, 30718, 30696, 30696, 30642, 30641, 30618, 30608, 30599, 30574, 30551, 30535, 30532, 30529, 30524, 30515, 30507, 30477, 30461, 30456, 30456, 30415, 30414, 30409, 30409, 30387, 30347, 30317, 30278, 30273, 30264, 30247, 30229, 30212, 30207, 30203, 30202, 30167, 30128, 30065, 30017, 29983, 29981, 29939, 29931, 29924, 29899, 29856, 29853, 29834, 29796, 29792, 29786, 29753, 29706, 29687, 29683, 29661, 29638, 29622, 29616, 29587, 29582, 29569, 29565, 29552, 29521, 29487, 29451, 29426, 29412, 29411, 29329, 29284, 29246, 29244, 29235, 29234, 29172, 29170, 29156, 29154, 29148, 29105, 29102, 29089, 29084, 29063, 29048, 29014, 28988, 28979, 28962, 28959, 28896, 28893, 28884, 28868, 28851, 28842, 28830, 28794, 28794, 28738, 28731, 28685, 28673, 28670, 28668, 28655, 28635, 28573, 28550, 28535, 28503, 28484, 28467, 28437, 28411, 28368, 28344, 28330, 28308, 28284, 28267, 28245, 28173, 28155, 28107, 28089, 28060, 28039, 28021, 28000, 27998, 27996, 27943, 27938, 27890, 27889, 27881, 27875, 27868, 27824, 27800, 27793, 27776, 27762, 27720, 27719, 27687, 27667, 27616, 27556, 27549, 27537, 27484, 27476, 27417, 27375, 27351, 27319, 27258, 27257, 27229, 27224, 27186, 27151, 27139, 27134, 27121, 27021, 27002, 26990, 26964, 26953, 26951, 26949, 26934, 26922, 26904, 26892, 26886, 26884, 26865, 26852, 26839, 26832, 26816, 26815, 26808, 26783, 26771, 26739, 26732, 26723, 26722, 26720, 26715, 26671, 26665, 26643, 26634, 26602, 26566, 26549, 26539, 26536, 26524, 26493, 26354, 26328, 26318, 26314, 26290, 26263, 26263, 26237, 26237, 26182, 26179, 26164, 26142, 26133, 26102, 26102, 26101, 26088, 26023, 26015, 26009, 25993, 25991, 25988, 25956, 25949, 25905, 25904, 25896, 25884, 25873, 25867, 25867, 25866, 25846, 25833, 25828, 25817, 25784, 25759, 25755, 25732, 25730, 25711, 25704, 25699, 25698, 25691, 25691, 25660, 25645, 25638, 25603, 25591, 25572, 25561, 25560, 25534, 25511, 25504, 25458, 25446, 25428, 25399, 25371, 25362, 25332, 25320, 25313, 25265, 25235, 25225, 25209, 25209, 25199, 25193, 25192, 25172, 25154, 25153, 25151, 25149, 25117, 25095, 25095, 25057, 25037, 25033, 24993, 24977, 24974, 24953, 24932, 24927, 24882, 24876, 24860, 24845, 24843, 24792, 24792, 24762, 24743, 24720, 24713, 24701, 24652, 24635, 24613, 24587, 24565, 24546, 24464, 24463, 24409, 24400, 24399, 24390, 24380, 24378, 24299, 24282, 24264, 24252, 24204, 24198, 24198, 24196, 24181, 24165, 24149, 24144, 24143, 24128, 24093, 24056, 24021, 24001, 23997, 23990, 23987, 23951, 23940, 23914, 23907, 23883, 23869, 23855, 23840, 23829, 23815, 23810, 23777, 23773, 23767, 23759, 23737, 23721, 23711, 23677, 23668, 23663, 23658, 23641, 23641, 23638, 23633, 23630, 23611, 23600, 23595, 23568, 23556, 23554, 23538, 23533, 23519, 23506, 23477, 23473, 23380, 23360, 23325, 23316, 23268, 23256, 23250, 23239, 23221, 23213, 23212, 23212, 23190, 23181, 23126, 23106, 23082, 23070, 23054, 23052, 23021, 23020, 23017, 22992, 22967, 22943, 22934, 22913, 22894, 22877, 22874, 22848, 22845, 22840, 22838, 22831, 22820, 22802, 22784, 22774, 22768, 22706, 22694, 22669, 22665, 22665, 22647, 22637, 22633, 22594, 22503, 22480, 22430, 22430, 22419, 22414, 22411, 22399, 22398, 22382, 22330, 22322, 22319, 22313, 22311, 22308, 22307, 22306, 22291, 22271, 22265, 22263, 22248, 22231, 22228, 22206, 22166, 22164, 22153, 22128, 22127, 22109, 22074, 22047, 22042, 22019, 22011, 21992, 21964, 21960, 21895, 21891, 21878, 21842, 21832, 21797, 21773, 21761, 21727, 21725, 21724, 21707, 21703, 21684, 21676, 21653, 21644, 21619, 21615, 21607, 21596, 21593, 21540, 21504, 21492, 21468, 21464, 21456, 21404, 21390, 21383, 21376, 21373, 21367, 21357, 21316, 21312, 21285, 21283, 21267, 21246, 21223, 21188, 21175, 21162, 21153, 21128, 21063, 21055, 21045, 21042, 21040, 21039, 21029, 21018, 20996, 20989, 20985, 20983, 20981, 20974, 20945, 20942, 20936, 20912, 20905, 20896, 20896, 20895, 20881, 20857, 20845, 20839, 20834, 20832, 20818, 20811, 20749, 20746, 20744, 20733, 20730, 20730, 20716, 20707, 20699, 20687, 20673, 20669, 20655, 20643, 20626, 20622, 20597, 20593, 20548, 20541, 20517, 20514, 20514, 20511, 20506, 20455, 20445, 20436, 20425, 20419, 20392, 20371, 20364, 20344, 20343, 20331, 20320, 20312, 20311, 20311, 20308, 20296, 20295, 20295, 20286, 20263, 20256, 20251, 20225, 20223, 20216, 20211, 20209, 20199, 20192, 20189, 20173, 20169, 20166, 20145, 20125, 20110, 20101, 20095, 20089, 20065, 20056, 20041, 20038, 20018, 20013, 19979, 19977, 19975, 19968, 19920, 19914, 19910, 19884, 19873, 19851, 19847, 19842, 19837, 19835, 19835, 19807, 19800, 19792, 19778, 19775, 19774, 19756, 19732, 19726, 19721, 19698, 19691, 19680, 19672, 19635, 19630, 19627, 19626, 19586, 19568, 19558, 19555, 19543, 19539, 19528, 19511, 19510, 19503, 19502, 19498, 19496, 19489, 19464, 19424, 19414, 19404, 19404, 19379, 19378, 19365, 19355, 19349, 19334, 19330, 19305, 19290, 19269, 19259, 19248, 19234, 19222, 19217, 19206, 19205, 19203, 19191, 19168, 19152, 19146, 19139, 19123, 19119, 19117, 19117, 19113, 19104, 19104, 19099, 19074, 19072, 19051, 19038, 19033, 19032, 19005, 18979, 18969, 18966, 18957, 18948, 18940, 18901, 18888, 18884, 18882, 18860, 18829, 18822, 18813, 18803, 18803, 18798, 18782, 18749, 18739, 18718, 18703, 18697, 18688, 18665, 18652, 18631, 18626, 18622, 18621, 18616, 18609, 18607, 18596, 18572, 18563, 18559, 18535, 18530, 18497, 18489, 18468, 18462, 18449, 18430, 18428, 18410, 18397, 18391, 18379, 18374, 18373, 18370, 18369, 18358, 18354, 18339, 18326, 18286, 18281, 18280, 18267, 18257, 18235, 18235, 18234, 18231, 18225, 18223, 18218, 18210, 18195, 18158, 18137, 18136, 18134, 18059, 18053, 18051, 18002, 17997, 17989, 17961, 17947, 17947, 17929, 17921, 17920, 17918, 17895, 17881, 17878, 17858, 17842, 17787, 17763, 17702, 17699, 17680, 17672, 17669, 17661, 17657, 17650, 17644, 17642, 17638, 17637, 17629, 17603, 17580, 17580, 17557, 17542, 17539, 17502, 17489, 17479, 17435, 17434, 17417, 17369, 17353, 17351, 17350, 17349, 17345, 17343, 17336, 17333, 17322, 17316, 17314, 17300, 17288, 17276, 17265, 17263, 17258, 17247, 17226, 17201, 17183, 17183, 17179, 17170, 17162, 17101, 17089, 17081, 17069, 17069, 17051, 17039, 17032, 17028, 17024, 17017, 17010, 17005, 16992, 16983, 16953, 16944, 16939, 16937, 16905, 16885, 16885, 16883, 16862, 16846, 16834, 16820, 16804, 16795, 16782, 16756, 16756, 16708, 16706, 16697, 16684, 16641, 16627, 16626, 16589, 16582, 16580, 16572, 16572, 16549, 16540, 16527, 16510, 16500, 16496, 16476, 16468, 16451, 16435, 16430, 16421, 16412, 16402, 16378, 16376, 16376, 16370, 16355, 16351, 16348, 16348, 16321, 16302, 16298, 16257, 16241, 16185, 16169, 16162, 16150, 16148, 16133, 16131, 16128, 16127, 16117, 16105, 16084, 16074, 16067, 16037, 16019, 16014, 15998, 15993, 15990, 15958, 15949, 15928, 15910, 15909, 15899, 15889, 15883, 15873, 15864, 15853, 15853, 15843, 15839, 15800, 15785, 15774, 15769, 15761, 15752, 15751, 15749, 15725, 15724, 15709, 15702, 15702, 15696, 15693, 15684, 15666, 15636, 15636, 15633, 15628, 15617, 15605, 15590, 15538, 15533, 15503, 15498, 15497, 15496, 15493, 15479, 15470, 15464, 15461, 15454, 15433, 15426, 15423, 15414, 15352, 15345, 15344, 15330, 15326, 15299, 15298, 15291, 15291, 15287, 15254, 15252, 15244, 15242, 15239, 15239, 15237, 15228, 15188, 15187, 15186, 15183, 15180, 15171, 15167, 15160, 15144, 15143, 15131, 15119, 15107, 15099, 15082, 15078, 15077, 15053, 15017, 15010, 15006, 14967, 14961, 14952, 14940, 14939, 14924, 14905, 14905, 14903, 14883, 14879, 14873, 14870, 14867, 14862, 14845, 14824, 14807, 14795, 14786, 14766, 14760, 14725, 14674, 14666, 14643, 14641, 14629, 14594, 14581, 14579, 14547, 14544, 14544, 14521, 14516, 14514, 14510, 14501, 14498, 14486, 14486, 14476, 14471, 14464, 14451, 14431, 14431, 14428, 14406, 14405, 14390, 14373, 14363, 14315, 14302, 14298, 14291, 14276, 14275, 14274, 14261, 14258, 14247, 14212, 14103, 14103, 14100, 14088, 14014, 13977, 13937, 13935, 13928, 13910, 13902, 13874, 13867, 13819, 13811, 13797, 13783, 13746, 13700, 13649, 13638, 13629, 13625, 13605, 13561, 13551, 13549, 13525, 13518, 13512, 13501, 13470, 13446, 13446, 13434, 13413, 13389, 13381, 13355, 13344, 13315, 13312, 13274, 13248, 13193, 13190, 13183, 13178, 13172, 13172, 13161, 13152, 13151, 13136, 13126, 13090, 13056, 12940, 12937, 12909, 12886, 12836, 12787, 12784, 12781, 12700, 12647, 12645, 12642, 12611, 12609, 12585, 12536, 12487, 12462, 12435, 12409, 12401, 12389, 12352, 12318, 12301, 12085, 12078, 12062, 12024, 12023, 12008, 12002, 11998, 11909, 11865, 11833, 11824, 11801, 11786, 11760, 11754, 11754, 11734, 11703, 11650, 11648, 11595, 11530, 11490, 11450, 11426, 11398, 11397, 11367, 11280, 11070, 10991, 10972, 10787, 10712, 10639, 10607, 10596, 10593, 10582, 10479, 10376, 10320, 10295, 10115, 9951, 9921, 9889, 9888, 9829, 9708, 9687, 9677, 9655, 9591, 9557, 9532, 9505, 9474, 9454, 9388, 9342, 9298, 9279, 9250, 9247, 9237, 9217, 9195, 9128, 9039, 9026, 8983, 8962, 8897, 8894, 8869, 8844, 8829, 8769, 8764, 8756, 8705, 8586, 8579, 8548, 8528, 8524, 8502, 8439, 8387, 8320, 8265, 8252, 8238, 8226, 8159, 8148, 8138, 8110, 8108, 8060, 8049, 8044, 8012, 8003, 7936, 7914, 7912, 7907, 7782, 7772, 7747, 7694, 7680, 7608, 7594, 7579, 7550, 7528, 7494, 7470, 7400, 7359, 7353, 7318, 7277, 7274, 7245, 7223, 7212, 7198, 7176, 7096, 7065, 7012, 6990, 6976, 6919, 6904, 6900, 6811, 6763, 6753, 6713, 6707, 6680, 6642, 6616, 6586, 6566, 6526, 6509, 6495, 6488, 6488, 6436, 6416, 6343, 6311, 6298, 6271, 6253, 6180, 6129, 6114, 6096, 6087, 6086, 6042, 5990, 5967, 5950, 5927, 5908, 5892, 5860, 5860, 5855, 5804, 5800, 5773, 5725, 5703, 5695, 5693, 5692, 5690, 5609, 5592, 5575, 5573, 5565, 5562, 5542, 5502, 5480, 5441, 5441, 5429, 5424, 5403, 5398, 5355, 5348, 5335, 5330, 5321, 5304, 5302, 5288, 5247, 5233, 5230, 5228, 5223, 5207, 5193, 5176, 5175, 5140, 5126, 5115, 5113, 5110, 5099, 5098, 5097, 5091, 5068, 5062, 5054, 5048, 5046, 5030, 5020, 5017, 5011, 4982, 4967, 4967, 4961, 4923, 4912, 4904, 4900, 4853, 4826, 4802, 4790, 4785, 4768, 4765, 4760, 4736, 4735, 4696, 4688, 4674, 4671, 4671, 4664, 4636, 4624, 4624, 4599, 4597, 4591, 4584, 4563, 4533, 4519, 4518, 4516, 4458, 4445, 4430, 4424, 4392, 4384, 4365, 4348, 4326, 4321, 4320, 4319, 4314, 4301, 4289, 4286, 4284, 4283, 4277, 4270, 4256, 4249, 4249, 4227, 4223, 4219, 4219, 4201, 4199, 4192, 4170, 4164, 4162, 4146, 4121, 4107, 4098, 4096, 4078, 4076, 4061, 4050, 4031, 4029, 4023, 4020, 4018, 3994, 3974, 3961, 3937, 3931, 3931, 3929, 3920, 3912, 3905, 3896, 3884, 3880, 3878, 3873, 3860, 3856, 3844, 3833, 3821, 3790, 3788, 3768, 3758, 3723, 3723, 3714, 3700, 3694, 3691, 3676, 3659, 3658, 3643, 3640, 3639, 3635, 3633, 3610, 3609, 3608, 3607, 3603, 3595, 3572, 3565, 3557, 3551, 3531, 3527, 3525, 3509, 3502, 3477, 3477, 3471, 3471, 3469, 3468, 3461, 3459, 3442, 3435, 3435, 3425, 3424, 3414, 3414, 3410, 3408, 3406, 3391, 3372, 3369, 3361, 3360, 3341, 3323, 3314, 3306, 3302, 3295, 3292, 3291, 3290, 3287, 3287, 3257, 3249, 3244, 3242, 3233, 3231, 3224, 3218, 3216, 3213, 3182, 3180, 3176, 3171, 3157, 3156, 3154, 3150, 3147, 3146, 3143, 3135, 3131, 3128, 3127, 3121, 3119, 3112, 3100, 3098, 3088, 3087, 3087, 3078, 3078, 3067, 3067, 3065, 3064, 3061, 3059, 3058, 3051, 3049, 3044, 3035, 3012, 3011, 2999, 2997, 2993, 2992, 2986, 2980, 2977, 2975, 2968, 2952, 2943, 2937, 2936, 2935, 2932, 2925, 2917, 2917, 2904, 2899, 2884, 2884, 2883, 2872, 2863, 2845, 2837, 2834, 2827, 2814, 2799, 2798, 2766, 2764, 2759, 2756, 2744, 2729, 2728, 2726, 2720, 2719, 2718, 2715, 2710, 2707, 2707, 2703, 2701, 2698, 2698, 2689, 2681, 2681, 2680, 2679, 2670, 2670, 2661, 2654, 2652, 2650, 2649, 2647, 2644, 2635, 2632, 2624, 2623, 2610, 2609, 2606, 2604, 2596, 2594, 2587, 2582, 2579, 2576, 2572, 2572, 2563, 2559, 2550, 2549, 2543, 2541, 2540, 2534, 2515, 2513, 2500, 2497, 2496, 2474, 2468, 2468, 2465, 2463, 2460, 2456, 2456, 2452, 2450, 2444, 2444, 2443, 2428, 2419, 2417, 2415, 2406, 2404, 2402, 2398, 2388, 2383, 2374, 2372, 2372, 2367, 2366, 2349, 2345, 2343, 2339, 2337, 2337, 2334, 2334, 2322, 2319, 2316, 2309, 2303, 2301, 2299, 2296, 2294, 2282, 2278, 2278, 2275, 2268, 2266, 2255, 2245, 2243, 2240, 2228, 2221, 2215, 2204, 2203, 2203, 2189, 2186, 2183, 2178, 2177, 2176, 2161, 2154, 2151, 2142, 2135, 2132, 2125, 2121, 2086, 2049, 2049, 2037, 2035, 2034, 2004, 2003, 2001, 1994, 1984, 1964, 1962, 1939, 1929, 1917, 1916, 1910, 1901, 1882, 1881, 1870, 1860, 1860, 1854, 1852, 1852, 1831, 1821, 1789, 1746, 1739, 1703, 1681, 1673, 1658, 1653, 1634, 1589, 1578, 1548, 1542, 1508, 1492, 1472, 1439, 1414, 1326, 1324, 1320, 1308, 1288]

19. Sắp xếp theo tần suất xuất hiện

Đưa ra tần suất xuất hiện của các giá trị trong cột 1; sắp xếp các giá trị trong cột 1 theo thứ tự từ cao đến thấp của tần suất xuất hiện. Xác nhận lại kết quả bằng việc dùng các lệnh cut, uniq, sort.

def frequency(input_file):

ret = {}

with open(input_file, 'r') as f:

for row in f:

l = row.strip().split('\t')

if l[0] in ret:

ret[l[0]] += 1

else:

ret[l[0]] = 1

print(sorted(ret.items(), key=lambda x:x[1], reverse=True))

input_file = 'popular-names.txt'

frequency(input_file)

[('James', 118), ('William', 111), ('John', 108), ('Robert', 108), ('Mary', 92), ('Charles', 75), ('Michael', 74), ('Elizabeth', 73), ('Joseph', 70), ('Margaret', 60), ('George', 58), ('Thomas', 58), ('David', 57), ('Richard', 51), ('Helen', 45), ('Frank', 43), ('Christopher', 43), ('Anna', 41), ('Edward', 40), ('Ruth', 39), ('Patricia', 38), ('Matthew', 37), ('Dorothy', 36), ('Emma', 35), ('Barbara', 32), ('Daniel', 31), ('Joshua', 31), ('Sarah', 26), ('Linda', 26), ('Jennifer', 26), ('Emily', 26), ('Jessica', 25), ('Jacob', 25), ('Mildred', 24), ('Betty', 24), ('Susan', 24), ('Henry', 23), ('Ashley', 23), ('Nancy', 22), ('Andrew', 21), ('Florence', 20), ('Marie', 20), ('Donald', 20), ('Amanda', 20), ('Samantha', 19), ('Karen', 18), ('Lisa', 18), ('Melissa', 18), ('Madison', 18), ('Olivia', 18), ('Stephanie', 17), ('Abigail', 17), ('Ethel', 16), ('Sandra', 16), ('Mark', 16), ('Frances', 15), ('Carol', 15), ('Angela', 15), ('Michelle', 15), ('Heather', 15), ('Ethan', 15), ('Isabella', 15), ('Shirley', 14), ('Kimberly', 14), ('Amy', 14), ('Ava', 14), ('Virginia', 13), ('Deborah', 13), ('Brian', 13), ('Jason', 13), ('Nicole', 13), ('Hannah', 13), ('Sophia', 13), ('Minnie', 12), ('Bertha', 12), ('Donna', 12), ('Cynthia', 11), ('Alice', 10), ('Doris', 10), ('Ronald', 10), ('Brittany', 10), ('Nicholas', 10), ('Mia', 10), ('Noah', 10), ('Joan', 9), ('Debra', 9), ('Tyler', 9), ('Ida', 8), ('Clara', 8), ('Judith', 8), ('Taylor', 8), ('Alexis', 8), ('Alexander', 8), ('Mason', 8), ('Harry', 7), ('Sharon', 7), ('Steven', 7), ('Tammy', 7), ('Brandon', 7), ('Liam', 7), ('Anthony', 6), ('Annie', 5), ('Gary', 5), ('Jeffrey', 5), ('Jayden', 5), ('Charlotte', 5), ('Lillian', 4), ('Kathleen', 4), ('Justin', 4), ('Austin', 4), ('Chloe', 4), ('Benjamin', 4), ('Evelyn', 3), ('Megan', 3), ('Aiden', 3), ('Harper', 3), ('Elijah', 3), ('Bessie', 2), ('Larry', 2), ('Rebecca', 2), ('Lauren', 2), ('Amelia', 2), ('Logan', 2), ('Oliver', 2), ('Walter', 1), ('Carolyn', 1), ('Pamela', 1), ('Lori', 1), ('Laura', 1), ('Tracy', 1), ('Julie', 1), ('Scott', 1), ('Kelly', 1), ('Crystal', 1), ('Rachel', 1), ('Lucas', 1)]

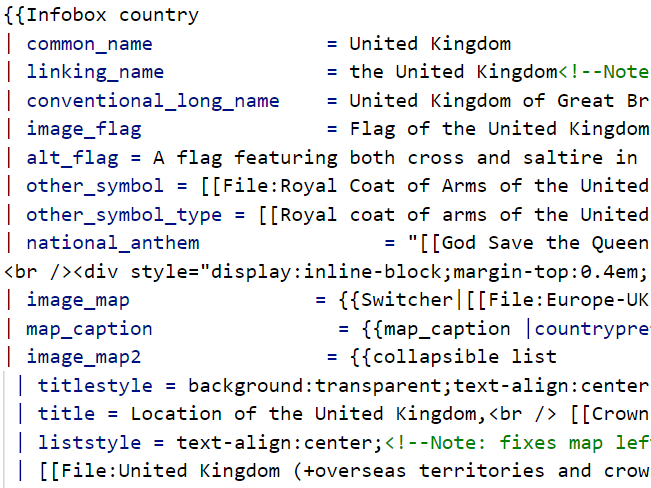

Chương 3: Biểu thức chính quy (Regular Expressions)

Tệp enwiki-country.json.gz lưu trữ các bài viết Wikipedia ở định dạng:

- Mỗi dòng lưu trữ một bài viết Wikipedia ở định dạng JSON.

- Mỗi tài liệu JSON có các cặp khóa-giá trị:

- Tiêu đề của bài viết là giá trị ứng với khóa "title".

- Phần nội dung của bài viết là giá trị ứng với khóa "text".

- Toàn bộ tập tin được nén bởi gzip.

Viết mã thực hiện các công việc sau.

!wget https://nlp100.github.io/data/enwiki-country.json.gz

20. Đọc vào dữ liệu JSON

Đọc các tài liệu JSON, trích xuất và hiển thị nội dung của bài viết về United Kingdom. Sử dụng các nội dung của tài liệu được trích xuất này để thực hiện các nhiệm vụ trong các bài tập từ 21-29.

import pandas as pd

input_file = 'enwiki-country.json.gz'

df = pd.read_json(input_file, lines=True)

ukText = df.query('title=="United Kingdom"')['text'].values[0]

print(ukText)

21. Trích xuất các dòng có chứa tên đề mục

Trong các tài liệu, trích xuất các dòng có chứa tên đề mục (category name).

import json

ukTextList = ukText.split('\n')

for data in ukTextList:

if '[[Category:' in data:

print(data)

22. Trích xuất các tên đề mục

Trích xuất tên đề mục của trong các tài liệu. Trong bài tập này, cần trích xuất chính xác các tên đề mục chứ không phải dòng chứa tên đề mục.

ukTextList = ukText.split('\n')

for data in ukTextList:

if '[[Category:' in data:

data = data.replace('[[Category:', '').replace('|*', '').replace(']]', '')

print(data)

23. Cấu trúc của các Section

Hiển thị tên của các section và level của các section trong các tài liệu Wikipedia (Ví dụ với section == Section Name ==" thì level bằng 1)

import re

repatter = re.compile("^[=+]")

for text in ukTextList:

if re.match(repatter, text):

print(int((len(text) - len(text.strip('='))) / 2 -1), text.strip('='))

24. Trích xuất các liên kết file

Trích xuất toàn bộ các liên kết đến các media files trong tài liệu.

import re

repatter = re.compile("\[\[*(file|ファイル)")

for text in ukTextList:

mache = re.search(repatter, text)

if mache:

print(re.split(r'[\||\]]', text[mache.span()[1]+1:])[0])

25. Infobox

Trích xuất tên trường và giá trị của chúng trong Infobox "country" và lưu trữ chúng trong một đối tượng từ điển (dictionary).

def ch025():

ls, fg = [], False

template = 'Infobox'

p1 = re.compile('\{\{' + template)

p2 = re.compile('\}\}')

p3 = re.compile('\|')

p4 = re.compile('<ref(\s|>).+?(</ref>|$)')

for l in ukText.split('\n'):

if fg:

ml = [p2.match(l), p3.match(l)]

if ml[0]:

break

if ml[1]:

ls.append(p4.sub('', l.strip()))

if p1.match(l):

fg = True

ret = {}

for l in ls:

d = l.strip('|').split('=')

ret[d[0]] = d[1]

return ret

from pprint import pprint

pprint(ch025())

26. Loại bỏ các emphasis markups

Trong khi làm các xử lý ở bài tập 25, xoá các MediaWiki emphasis markup (italic, bold, both) trong giá trị của các trường và biến đổi thành plain text. Xem thêm tại Help:Cheatsheet.

def remove_stress(basic_information):

r = re.compile("''+")

return {k: r.sub('', v) for k, v in basic_information.items()}

ch26 = remove_stress(ch025())

27. Xóa bỏ các Internal Links

Bên cạnh những xử lý trong bài tập 26, hãy xóa những liên kết trong từ các giá trị của các trường. Xem thêm tại Help:Cheatsheet.

def remove_inner_links(basic_information):

pattern = re.compile('\[\[.+\]\]')

for k, v in basic_information.items():

#print(v)

text = v.strip()

if re.match(pattern, text):

l = re.sub('\[\[|\]\]', '', text).split('|')

if ':' not in l [0]:

basic_information[k] = l[0]

return basic_information

ch27 = remove_inner_links(ch26)

28. Xoá các markup trong văn bản

Ngoài các xử lý ở bài 27, hãy xoá các Media markup trong các giá trị của các trường ở Infobox càng nhiều càng tốt và in ra các thông tin cơ bản về quốc gia ở dạng plaintext.

import re

def remove_file_link(text):

r = re.compile(u'^\[\[(?:ファイル|File):(?P<name>.+?)\|.+')

return r.sub('\g<name>', text)

def remove_lang(text):

r = re.compile(u'{{lang\|.+\|(?P<name>.+?)}}')

return r.sub('\g<name>', text)

def remove_external_link(text):

r = re.compile(r'\['

r'(?P<url>\S+)'

r'\s?'

r'(?P<name>.+?)?'

r'\]')

m = r.search(text)

if m is None:

return text

if m.group('name'):

return m.group('name')

return m.group('url')

data = load_data()

info = extract_basic_info(data)

for key, val in info.items():

print('key = {}'.format(key.encode('utf8')))

val = remove_emphasis(val)

val = remove_internal_link(val)

val = remove_external_link(val)

val = remove_file_link(val)

val = remove_lang(val)

print('value = {}\n'.format(val.encode('utf8')))

29. Lấy ra các URL của quốc kỳ

Lấy URL của quốc gia bằng cách sử dụng kết quả phân tích của Infobox. (Gợi ý: chuyển đổi tham chiếu file thành URL bằng cách gọi imageinfo trong MediaWiki API)

import requests

def get_url(basic_information):

url_file = basic_information['国旗画像 '].replace(' ', '_')

url = 'https://commons.wikimedia.org/w/api.php?action=query&titles=File:' + url_file + '&prop=imageinfo&iiprop=url&format=json'

data = requests.get(url)

return re.search(r'"url":"(.+?)"', data.text).group(1)

get_url(ch27)

'https://upload.wikimedia.org/wikipedia/commons/a/ae/Flag_of_the_United_Kingdom.svg'

Chương 4: Morphological Analysis trong tiếng Nhật (形態素解析)

Dùng MeCab để phân tích hình thái cho nội dung text của cuốn tiểu thuyết "Tôi là một con mèo" (neko.txt) tác giả Soseki Natsume, và lưu kết quả vào file neko.txt.mecab. Sử dụng file kết quả để thực hiện các công việc ở các bài tập dưới đây.

Đối với các bài tập 37, 38, 39, có thể sử dụng các phần mềm matplitlib hoặc Gnuplot.

!wget https://nlp100.github.io/data/neko.txt

!apt install aptitude

!aptitude install mecab libmecab-dev mecab-ipadic-utf8 git make curl xz-utils file -y

!pip install mecab-python3==0.7

30. Đọc vào kết quả morphological analysis

Viết chương trình đọc vào kết quả morphological analysis (file neko.txt.mecab).

Yêu cầu: Với mỗi morpheme, lưu các thông tin: 表層形 (surface form), 基本形 (base form), 品詞 (pos), 品詞細分類 1 (pos1) bằng cấu trúc dữ liệu hash map với các key tương ứng là: surface, base, pos, pos1. Lưu trữ mỗi câu bằng danh sách của các morpheme. Trong các bài tập còn lại trong chương 4, hãy sử dụng cách tổ chức dữ liệu trong bài này.

def parseMecab(block):

res = []

for line in block.split('\n'):

if line == '':

return res

(surface, attr) = line.split('\t')

attr = attr.split(',')

lineDict = {

'surface': surface,

'base': attr[6],

'pos': attr[0],

'pos1': attr[1]

}

res.append(lineDict)

filename = 'neko.txt.mecab'

with open(filename, mode='rt', encoding='utf-8') as f:

block_list = f.read().split('EOS\n')

block_list = list(filter(lambda x: x != '', block_list))

block_list = [parseMecab(block) for block in block_list]

for b in block_list[1]:

print(b)

31. Động từ

Trích xuất tất cả các surface forms của động từ (pos=動詞).

def extract(block, mode):

res = list(filter(lambda x: x['pos'] == '動詞', block))

res = [r[mode] for r in res]

return res

cnt = 0

for b in block_list:

ret = extract(b, mode='surface')

print(ret)

cnt += 1

if cnt >= 10:

break

[]

[]

[]

[]

[]

['生れ', 'つか']

['し', '泣い', 'し', 'いる']

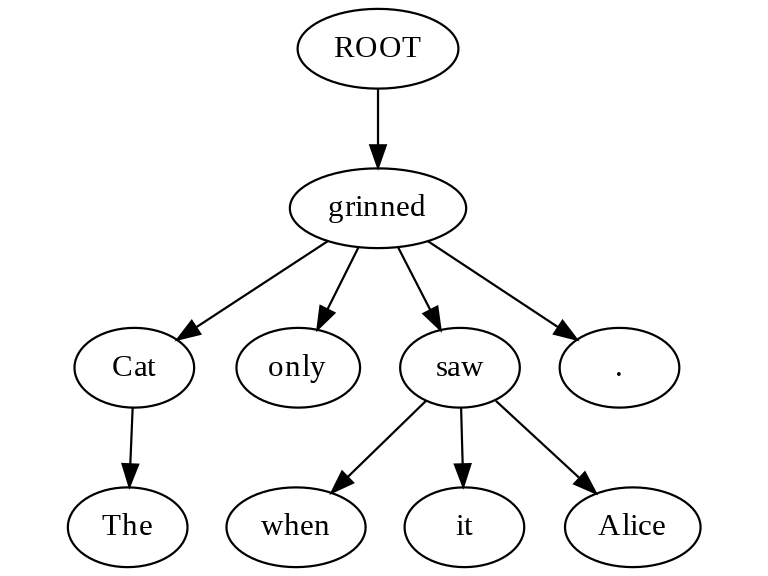

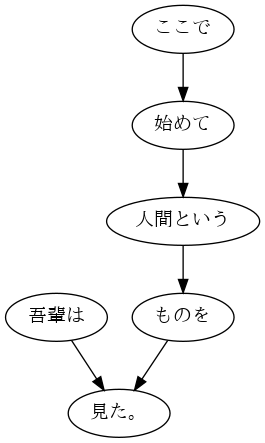

['始め', '見']

['聞く']

['捕え', '煮', '食う']

32. Dạng nguyên thể của động từ (動詞の原形)

Trích xuất tất cả dạng nguyên thể của động từ (base form).

cnt = 0

for b in block_list:

ret = extract(b, mode='base')

print(ret)

cnt += 1

if cnt >= 10:

break

[]

[]

[]

[]

[]

['生れる', 'つく']

['する', '泣く', 'する', 'いる']

['始める', '見る']

['聞く']

['捕える', '煮る', '食う']

33.「A の B」

Trích xuất tất cả các danh từ ghép (compound nouns) gồm 2 danh từ kết nối bằng の.

def extract(block):

if len(block) <=3:

return

res = []

for i in range(1, len(block) - 1):

if block[i-1]['pos'] == '名詞' and block[i]['surface'] == 'の' and block[i+1]['pos'] == '名詞':

res.append([block[i-1], block[i], block[i+1]])

return res

cnt = 0

for b in block_list:

res = extract(b)

if res:

for noun_phrase in res:

print(noun_phrase[0]['surface'], noun_phrase[1]['surface'], noun_phrase[2]['surface'])

cnt += 1

if cnt >= 40:

break

彼 の 掌

掌 の 上

書生 の 顔

はず の 顔

顔 の 真中

穴 の 中

書生 の 掌

掌 の 裏

何 の 事

肝心 の 母親

藁 の 上

笹原 の 中

池 の 前

34. Trích xuất các kết nối danh từ (noun connections hay 名詞の連接)

Trích xuất tất cả các noun connections (các danh từ đứng cạnh nhau liên tiếp). Khi trích xuất, chú ý trích xuất chuỗi danh từ matching dài nhất có thể. Ví dụ ABC trong đó A, B, C là danh từ thì phải trích xuất ABC thay vì AB.

def extract(block):

res = []

res_candidate = []

for token in block:

if token['pos'] == '名詞':

res_candidate.append(token)

elif token['pos'] != '名詞' and len(res_candidate) >= 2:

print(res_candidate)

res.extend(res_candidate)

res_candidate.clear()

elif token['pos'] != '名詞' and len(res_candidate) < 2:

res_candidate.clear()

return res

cnt = 0

for b in block_list:

res = extract(b)

#print(res)

cnt += 1

if cnt >= 10:

break

[{'surface': '人間', 'base': '人間', 'pos': '名詞', 'pos1': '一般'}, {'surface': '中', 'base': '中', 'pos': '名詞', 'pos1': '接尾'}]

[{'surface': '一番', 'base': '一番', 'pos': '名詞', 'pos1': '副詞可能'}, {'surface': '獰悪', 'base': '獰悪', 'pos': '名詞', 'pos1': '形容動詞語幹'}]

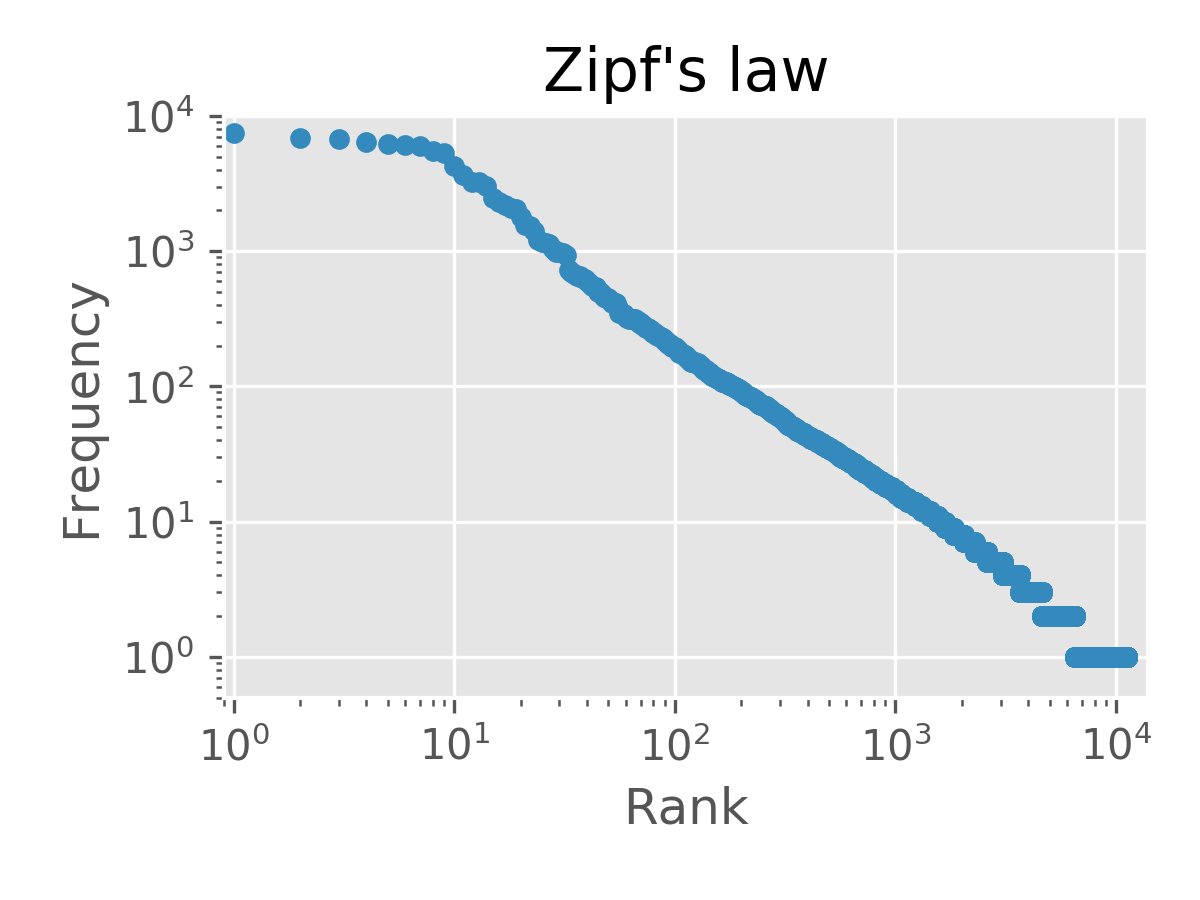

35. Tần suất xuất hiện của từ

Lập trình tính tần suất xuất hiện của từ trong văn bản. Đưa ra các từ theo thứ tự giảm dần của tần suất xuất hiện.

def extract(block):

res = []

res_candidate = []

for token in block:

if token['pos'] == '名詞':

res_candidate.append(token)

elif token['pos'] != '名詞' and len(res_candidate) >= 2:

print(res_candidate)

res.extend(res_candidate)

res_candidate.clear()

elif token['pos'] != '名詞' and len(res_candidate) < 2:

res_candidate.clear()

return res

cnt = 0

for b in block_list:

res = extract(b)

#print(res)

cnt += 1

if cnt >= 10:

break

[{'surface': '人間', 'base': '人間', 'pos': '名詞', 'pos1': '一般'}, {'surface': '中', 'base': '中', 'pos': '名詞', 'pos1': '接尾'}]

[{'surface': '一番', 'base': '一番', 'pos': '名詞', 'pos1': '副詞可能'}, {'surface': '獰悪', 'base': '獰悪', 'pos': '名詞', 'pos1': '形容動詞語幹'}]

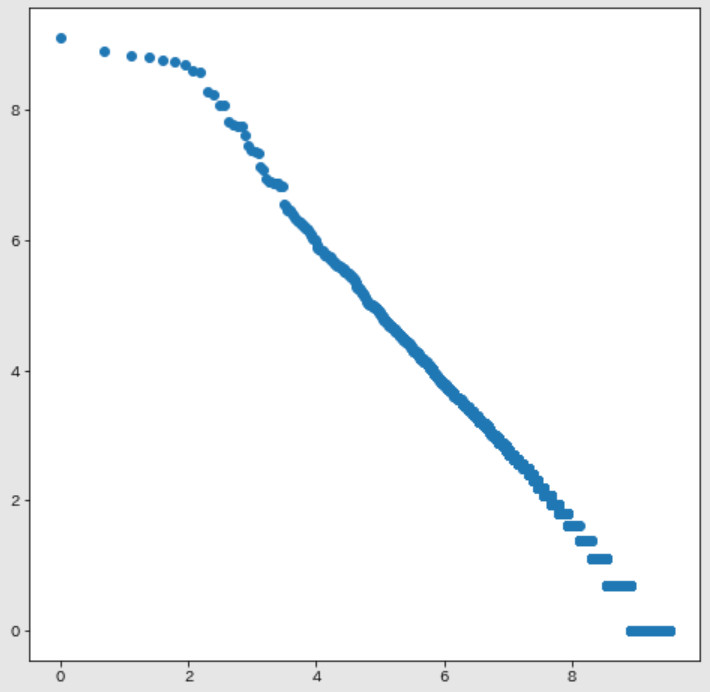

36. Top 10 từ xuất hiện nhiều nhất

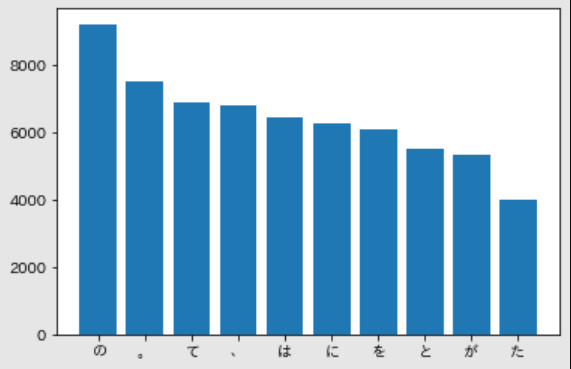

Vẽ đồ thị (ví dụ bar graph) của tần suất xuất hiện của 10 từ xuất hiện nhiều nhất trong văn bản.

# Loại bỏ các ký tự tiếng Nhật bị cắt xén !

!pip install japanize-matplotlib

import numpy as np

import matplotlib.pyplot as plt

import japanize_matplotlib

def plot_frequency_token(block_list, top=10):

res = {}

for block in block_list:

for token in block:

ts = token['surface']

if ts in res:

res[ts] += 1

else:

res[ts] = 1

#print(len(res))

frequency_top = sorted(res.items(), key=lambda x:-x[1])

#print(frequency_top[0][1])

left = np.array([i+1 for i in range(top)])

height = np.array([token[1] for token in frequency_top[:top]])

label = [token[0] for token in frequency_top[:top]]

plt.bar(left, height, tick_label=label, align="center")

plt.show()

plot_frequency_token(block_list)

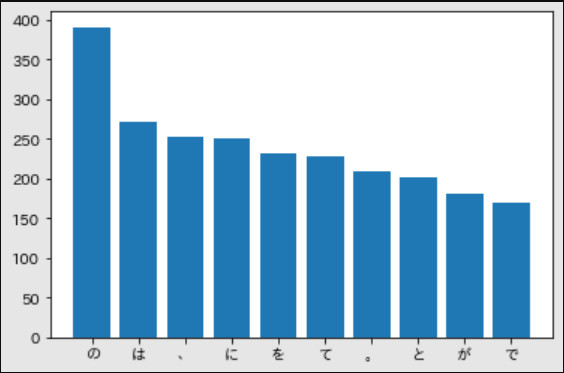

37. Top 10 từ đồng xuất hiện với từ 猫

Vẽ đồ thị (ví dụ: bar plot) tần suất xuất hiện của top 10 từ đồng xuất hiện nhiều nhất với từ 猫.

import numpy as np

import matplotlib.pyplot as plt

import japanize_matplotlib

def extract(block):

return [b['surface'] for b in block]

def plot_collocation(block_list, word, top=10):

res = {}

token_list = [extract(block) for block in block_list]

token_list = list(filter(lambda x: word in x, token_list))

for line in token_list:

for token in line:

if token != '猫':

if token in res:

res[token] += 1

else:

res[token] = 1

frequency_top = sorted(res.items(), key=lambda x:-x[1])

left = np.array([i+1 for i in range(top)])

height = np.array([token[1] for token in frequency_top[:top]])

label = [token[0] for token in frequency_top[:top]]

plt.bar(left, height, tick_label=label, align="center")

plt.show()

plot_collocation(block_list, word='猫')

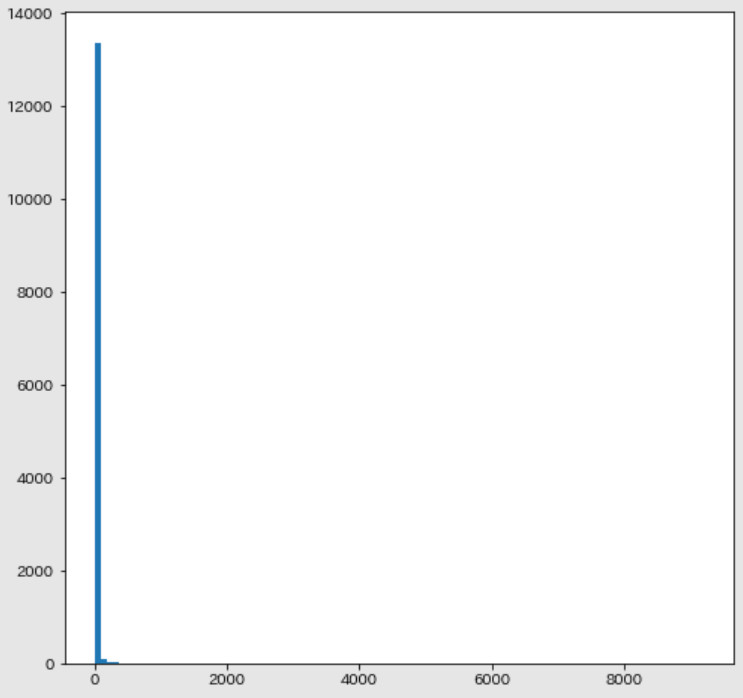

38. Histogram

Vẽ đồ thị histogram tần suất xuất hiện của các từ. Trục ngang là tần suất xuất hiện. Trục dọc là các từ.

import numpy as np

import matplotlib.pyplot as plt

import japanize_matplotlib

def extract(block):

return [b['surface'] for b in block]

def plot_frequency_hist(block_list):

res = {}

token_list = [extract(block) for block in block_list]

for line in token_list:

for token in line:

if token in res:

res[token] += 1

else:

res[token] = 1

ans = res.values()

print(sorted(ans, reverse=False))

plt.figure(figsize=(8, 8))

plt.hist(ans, bins=100)

plt.show()

plot_frequency_hist(block_list)